Ollama本地部署DeepSeek教程

- 作者:陈敬(http://www.jyes.top)

概述

本教程将指导你如何在本地部署DeepSeek模型,配置CherryStudio,并使用Java API进行请求。DeepSeek是一个强大的AI模型,适用于多种自然语言处理任务。通过本教程,你将能够轻松地在本地环境中运行和使用该模型。

环境准备

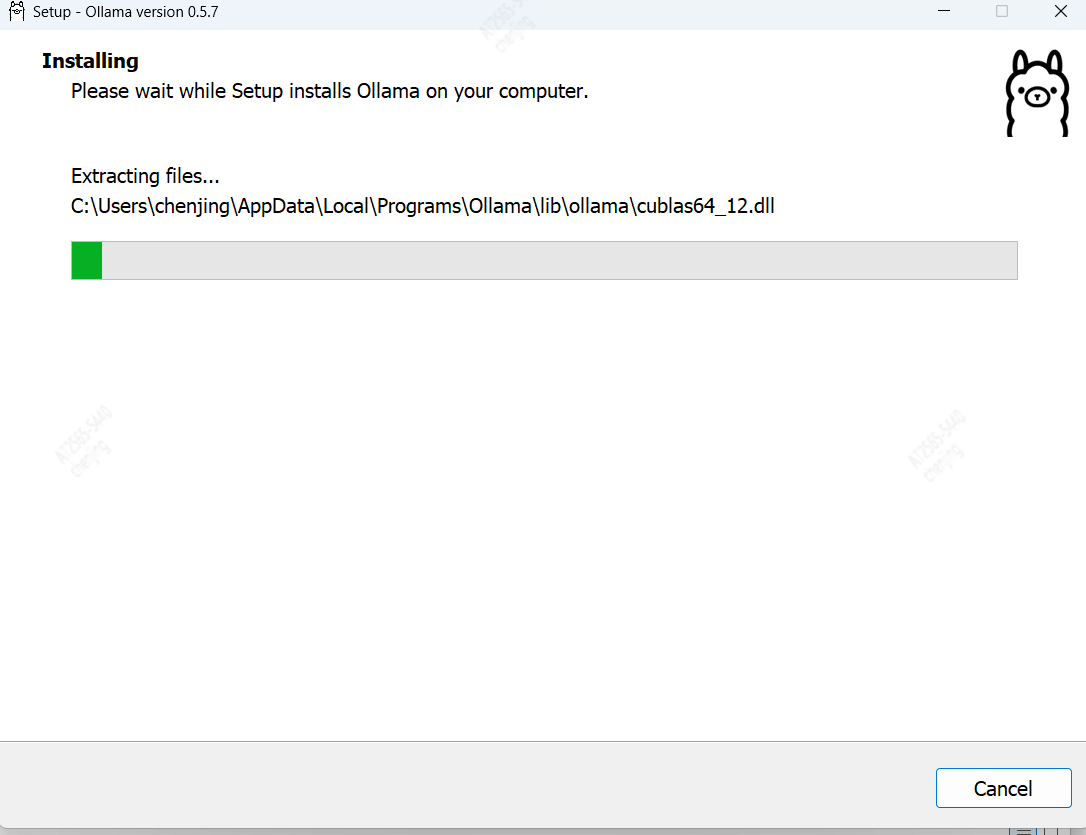

一、下载并安装Ollama

首先,你需要下载并安装Ollama,这是一个用于管理AI模型的工具。

-

访问Ollama官网并下载适合你操作系统的安装包。

-

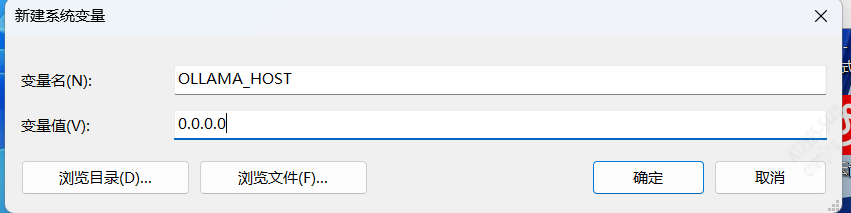

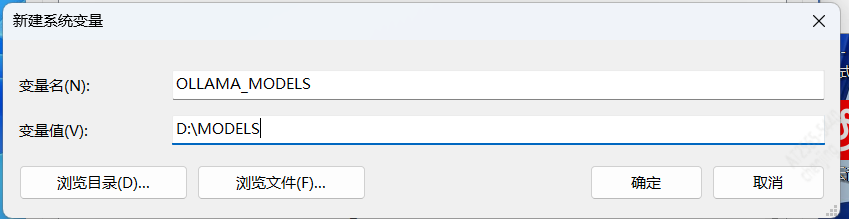

安装完成后,设置以下环境变量:

OLLAMA_HOST=0.0.0.0

OLLAMA_MODELS=D:\MODELS

-

重启你的计算机以使环境变量生效。

-

打开命令行工具,运行以下命令以验证Ollama是否安装成功:

ollama list

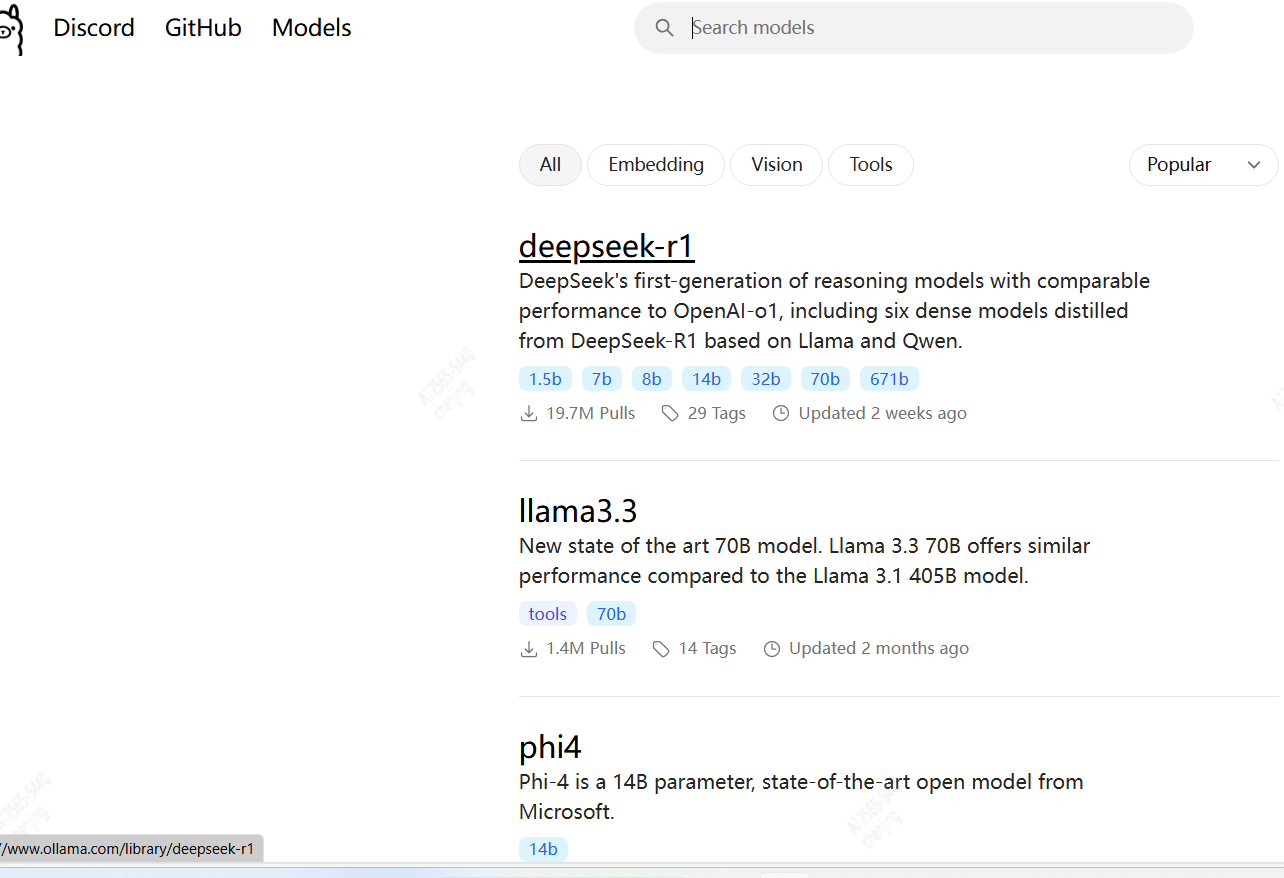

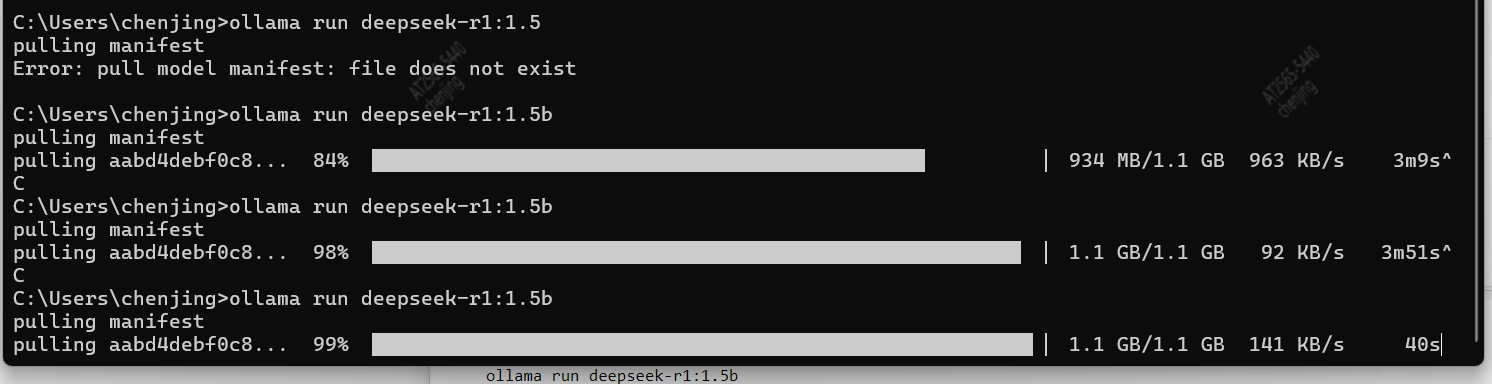

二、 部署DeepSeek模型

接下来,我们将部署DeepSeek模型。

-

访问Ollama官网并在模型库中搜索

deepseek-r1。

-

由于本机配置较低,我们选择下载1.5b版本。

-

在命令行中运行以下命令以下载并运行DeepSeek模型:

ollama run deepseek-r1:1.5b

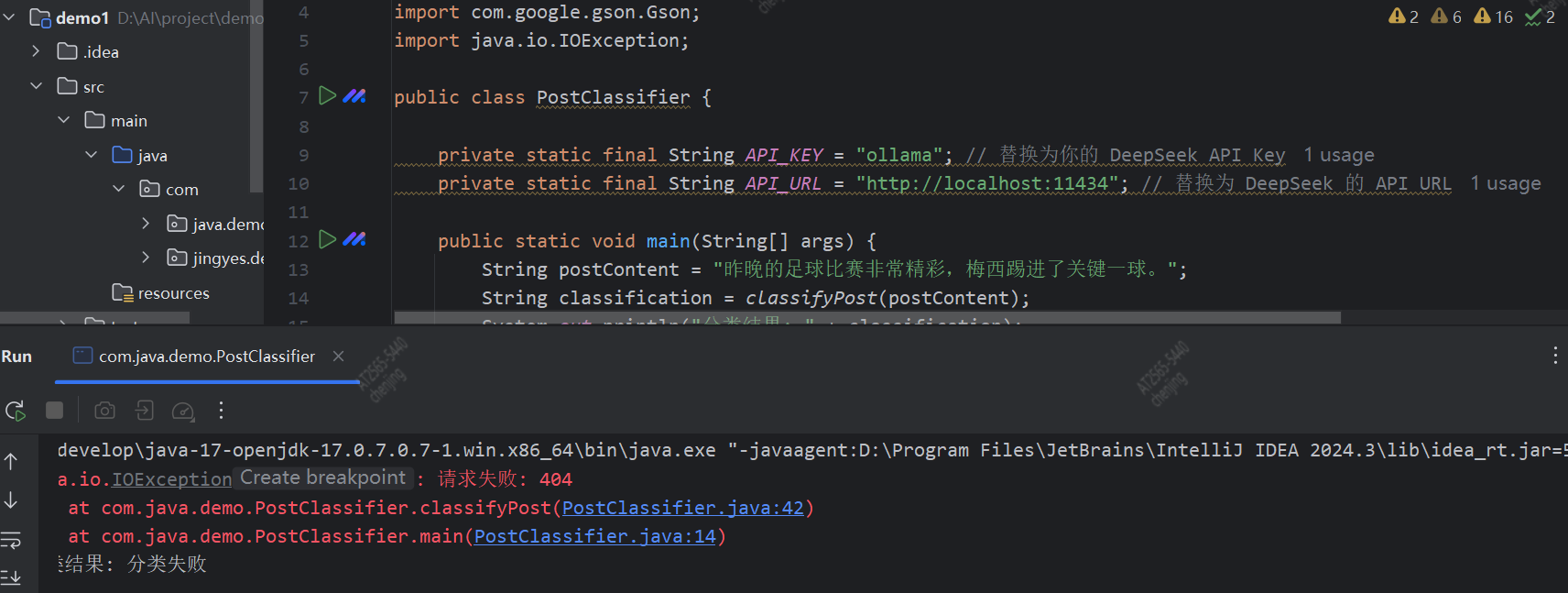

三、使用Java API调用DeepSeek

为了在你的Java应用程序中使用DeepSeek模型,你可以通过API进行调用。以下是一个简单的Java代码示��例:

import okhttp3.*;

import java.io.IOException;

public class DeepSeekModelClient {

private static final String API_URL = "http://localhost:11434/api/generate";

public static void main(String[] args) {

OkHttpClient client = new OkHttpClient();

// 构建请求体

MediaType JSON = MediaType.parse("application/json; charset=utf-8");

String json = "{\"model\": \"deepseek-r1:1.5b\", \"prompt\": \"Your input text here\"}";

RequestBody body = RequestBody.create(json, JSON);

// 构建请求

Request request = new Request.Builder()

.url(API_URL)

.post(body)

.build();

// 发送请求并处理响应

try (Response response = client.newCall(request).execute()) {

if (response.isSuccessful() && response.body() != null) {

String responseBody = response.body().string();

System.out.println("Response: " + responseBody);

} else {

System.out.println("Request failed with code: " + response.code());

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

代码说明

API_URL: 这是Ollama的API地址,模型将通过这个地址接收请求并返回响应。model: 指定要使用的模型名称,这里我们使用deepseek-r1:1.5b。prompt: 这是你想要传递给模型的输入文本。

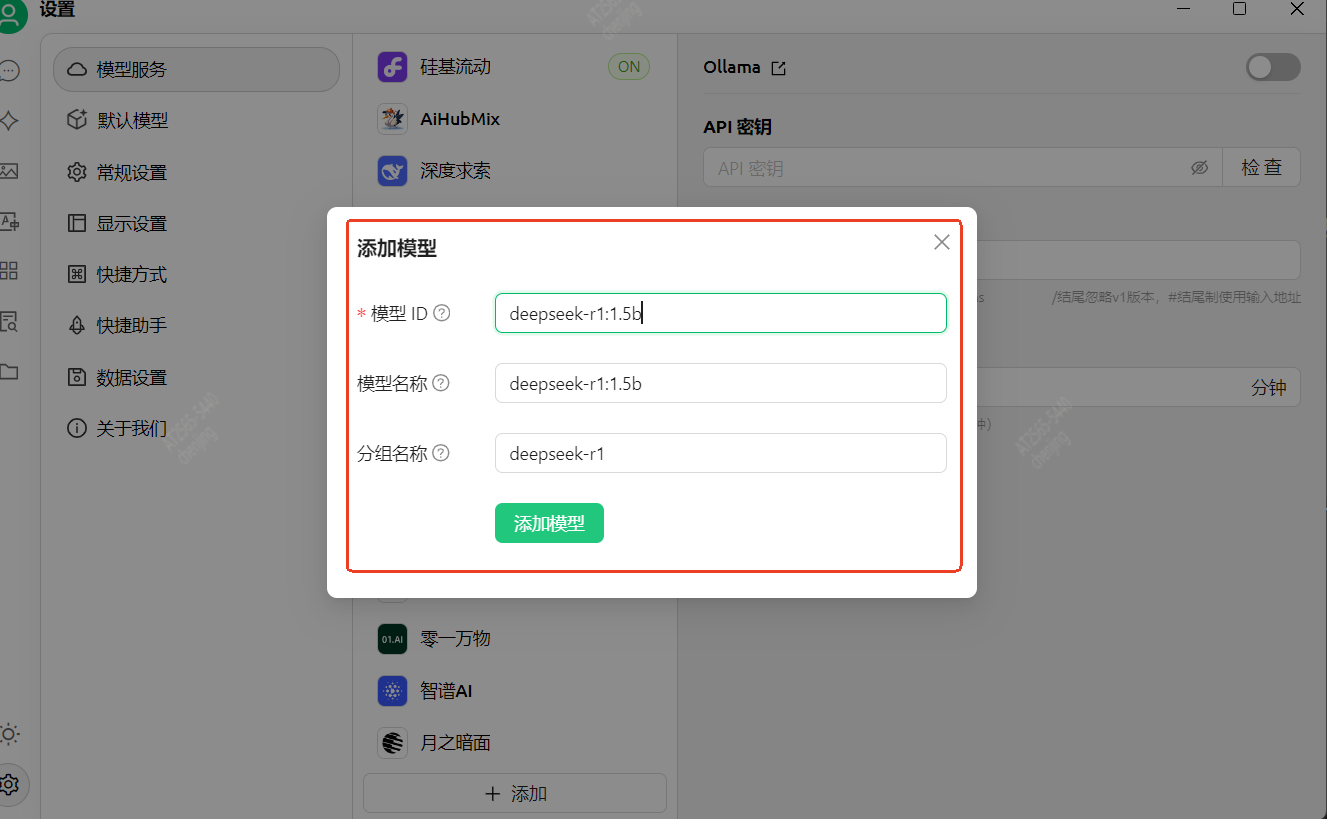

四、将DeepSeek添加到CherryStudio

如果你使用CherryStudio进行模型管理和服务,你可以将本地的DeepSeek模型添加到其中。

-

打开CherryStudio,进入

模型服务->ollama。 -

添加模型,填写以下信息:

- 模型ID:

deepseek-r1:1.5b - 模型名称:

deepseek-r1:1.5b - 分组名称:

deepseek-r1

- 模型ID:

-

设置完成后,你就可以在CherryStudio中使用该模型了。

]

]

总结

通过本教程,你已经成功在本地部署了DeepSeek模型,并使用Java API进行了调用。此外,你还学会了如何将模型添加到CherryStudio中进行管理。希望这篇教程对你有所帮助。

Happy Coding!